El peligro de la minería de datos en estrategias de apuestas deportivas: ¿Cómo evitar caer en la trampa?

Este artículo ha sido escrito y elaborado por Daniel Muñoz, le puedes seguir a través de Twitter en su cuenta DANI84 @DMN1984ADS.

Desde Betaminic agradecemos a Dani el excelente trabajo realizado para la elaboración de este artículo y poder compartir con todos nosotros su amplio conocimiento y experiencia en el ámbito de la estadística aplicada a las apuestas deportivas.

En los últimos tiempos se han puesto muy de moda las estrategias de apuestas basadas en patrones rentables obtenidos de la minería de datos, esto es algo así como buscar en grandes bases de datos con histórico de resultados y cuotas. Existen hoy día muchas plataformas que venden software especializado o bien ellos mismos venden sus pronósticos como cualquier otro tipster del mercado; el objetivo de este artículo es analizar una de estas plataformas, “Betaminic”, surgida hace ya algún tiempo y que ahora ha decidido dar un paso algo más profesional. Para dicho análisis utilizaremos como ejemplo algunas de las propias estrategias públicas de esta plataforma a la fecha actual y las analizaremos gráficamente, con el fin de identificar en qué medida sus resultados son fruto de patrones rentables o ineficiencias del mercado. Con el objetivo de hacer este artículo asequible a todo el público emplearemos un lenguaje sencillo y omitiremos fórmulas matemáticas, representando los resultados en formato gráfico.

Buscando en las bases de datos

Para explicar este punto vamos a poner un ejemplo ficticio que bien puede darse en cualquier momento:

Digamos que tenemos una base de datos bastante considerable, en ella tenemos registradas más de 50 ligas con resultados, cuotas de cierre de Pinnacle Sports y demás variables. Encontramos que apostar a favor del equipo visitante sistemáticamente ha sido rentable en un par de ligas en los últimos 3 años, y hemos obtenido un 12% de yield lo cual no está nada mal.

¿Pero de verdad esto es tan sencillo?

Evidentemente no, y lo más probable es que estos resultados sean en gran medida fruto del azar, pero cuidado porque esto no quiere decir que una pequeña parte de esa rentabilidad nos la hubiera regalado el mercado y sea una ineficiencia puntual que tarde o temprano se corregirá. La rutina de muchos apostantes que manejan software de pago especializado en el tema es precisamente la comentada anteriormente, encuentran un patrón rentable en esa serie y creen erróneamente que existe una causalidad y que ese patrón seguirá dándose en el futuro.

Es entonces cuando el apostante que ha identificado ese patrón cree tener el santo grial y ha llegado el momento de meter dinero real para replicar esas apuestas en la serie venidera, pero entonces sucede lo de siempre que la cosa no es como esperaba y ahora apostar a favor del visitante en ese par de ligas está arrojando pérdidas, es más ahora resulta que atendiendo a los valores de esta nueva serie lo que está dando yield positivo es apostar al equipo local. El apostante está muy confundido y vuelve a hacer backtest con su software especializado, ahora se ha dado cuenta que apostar al under 2,5 goles en otro par de ligas tiene casi un 10% de yield en las últimas temporadas, pero ya no se fía de lo que ve y esta vez para estar seguro va a aplicar una serie de filtros:

-Tomará sólo los equipos cuyos partidos han tenido mayor % de unders.

-Tomará sólo cuotas dentro de un rango.

Vuelta a empezar, es momento de meter dinero real a esta estrategia que además ha sido optimizada y que en el backtest ha pasado del 10% al 25% de yield con esta pequeña optimización, la cosa promete…

Empieza esa nueva serie y el patrón que se había dado en el pasado no se parece en nada a los resultados que están sucediendo en esas ligas, los equipos under ahora ya no son tan under y las cuotas ahora son perdedoras dejando un yield negativo.

¿Qué ha sucedido?

Pues ha sucedido lo esperado, los datos han regresado a la media y el mercado se ha autocorregido volviendo a ser bastante eficiente. Este apostante ficticio ha cometido errores de bulto; en primer lugar, no ha considerado variables de origen fundamental en sus filtros y por tanto lo que había descubierto no era un patrón rentable sino un patrón aleatorio y, es más, ha exprimido sus filtros adecuando la serie analizada. A esto se le llama sobre optimización y es el mayor peligro que podemos encontrarnos cuando utilizamos la minería de datos.

Si encima de haber encontrado un patrón aleatorio le aplicamos filtros como el de tomar sólo los equipos que han sido rentables, el patrón se vuelve todavía más aleatorio y lo que se está haciendo es adecuar los datos a nuestro interés que no es otro que buscar la combinación que nos dé el mayor yield posible, pero no es tan sencillo y de hecho como he mencionado, lo que nos encontraremos la mayor parte del tiempo son patrones aleatorios que en la próxima serie se comportarán de manera totalmente diferente.

Estudiamos las estrategias de Betaminic

En Betaminic nos ofrecen como producto estrella cuatro estrategias de apuestas que han obtenido unos fabulosos resultados en el pasado, las estrategias son las siguientes:

- E1: “TODAS las LIGAS Empate rompiendo racha”

- E2: “TODAS las LIGAS Equipo Local mala racha”

- E3: “TODAS las LIGAS Equipo Local SIN marcar”

- E4: “TODAS las LIGAS Más 2.5 contra tendencia”

Las cuatro estrategias tienen una rutina muy parecida, consiste en apostar a una determinada opción en un partido cuando se cumplen una serie de requisitos preestablecidos. Por una parte, tenemos lo que yo llamo variables de control (C) y por otro lado variables de origen fundamental (F). Cuando el sistema da una señal se realiza la apuesta.

Por ejemplo, la estrategia de apostar al “Empate” tiene dos variables de control:

C1: Cuota de apertura en Pinnacle Sports del equipo local @2,00 – @2,70

C2: Cuota de apertura en Pinnacle Sports del +2,5 goles @2,20 – @1000

Estas variables de control se utilizan para hacer una clasificación previa de los partidos ya que al ser un sistema automático no se puede realizar un análisis fundamental previo para hacer la selección. Por tanto, lo tomaremos como tal sin dar nada por hecho, ni siquiera el peligro de estar sobre optimizando de buen comienzo.

Variables de origen fundamental:

F1: Local debe tener una racha de mínimo 1 partido sin empatar (local / visitante).

F2: Visitante debe tener una racha de 2-3 partidos sin empatar (local / visitante).

La idea de la estrategia es esperar una regresión a la media. Con las variables de control que hemos aplicado, la casa de apuestas ha hecho la primera parte del trabajo y nos ha arrojado una serie de partidos donde, por las cuotas de apertura, tenemos partidos bastante equilibrados.

En la segunda parte, con las variables F, la idea es apostar al empate con su cuota de cierre en Pinnacle pensando que al existir esta pequeña racha el mercado ha fijado esa cuota de empate un poco más alta de lo que debería y pudiera existir valor.

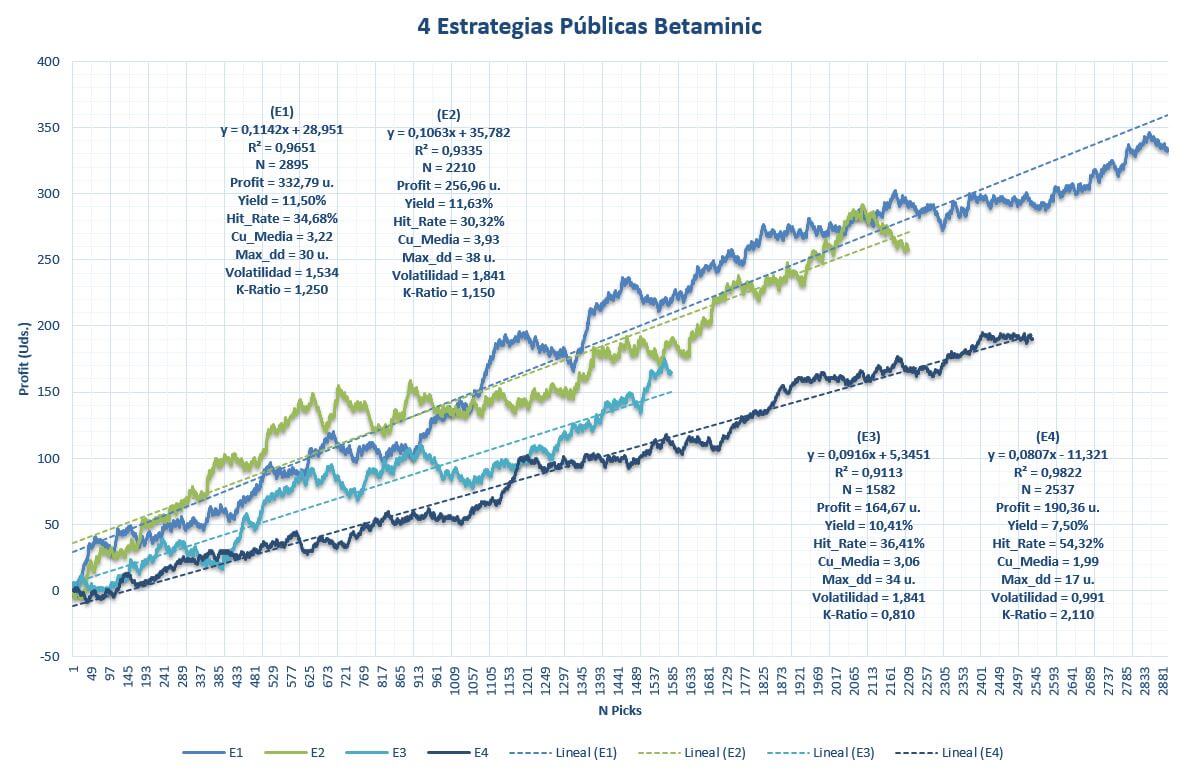

Las demás estrategias tienen un fundamento bastante similar al explicado anteriormente. Veamos a continuación un gráfico con el backtest de las cuatro estrategias:

El gráfico muestra el beneficio acumulado junto con variables cuantitativas de las estrategias. De entrada, los resultados son espectaculares tanto en yield como en volatilidad, y además la muestra de cada estrategia es >1.500 picks en todos los casos. El drawdown es más que aceptable para la gran cantidad de picks y las rectas dibujan un beneficio bastante consistente en el tiempo.

¿Son estos resultados estadísticamente significativos?

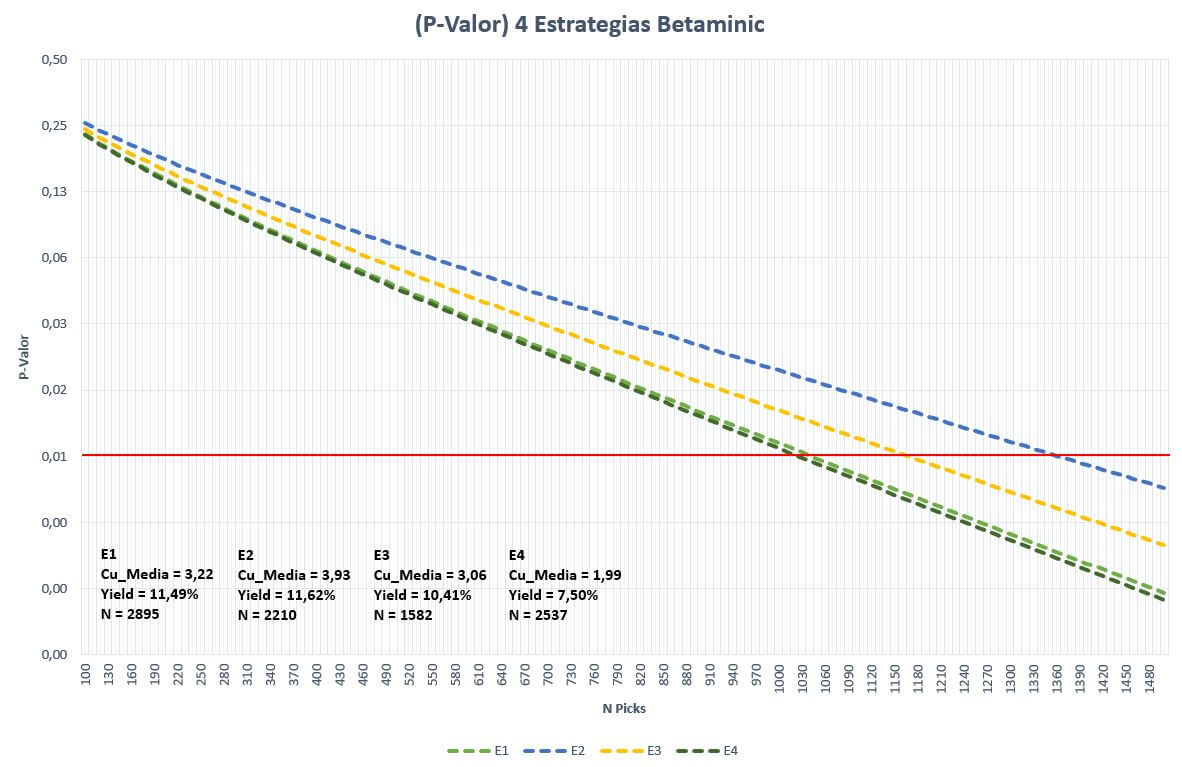

Podemos realizar una prueba de hipótesis para el supuesto de que los resultados de estas estrategias han sido fruto del azar:

Hipótesis nula: los resultados son fruto del azar.

Hipótesis alternativa: los resultados son fruto de algo que no es azar.

Para más seguridad vamos a fijar el nivel de significancia en el 1% (0,01). Entonces, tomando los datos del yield, número de picks y cuota media, se obtienen las líneas representadas en el gráfico. Cuando la línea discontinua de cada estrategia cruza la horizontal roja (significancia 1%), podemos afirmar que el resultado de esa muestra es estadísticamente significativo rechazando la hipótesis nula y dando por válida la alternativa, que en este caso sugiere que los resultados no provienen del azar.

Como se aprecia en el gráfico, para los niveles de yield de las estrategias, el número de picks necesario para esa significación estadística ya ha sido superado en los cuatro casos. ¿Es esto prueba suficiente de que los resultados no son fruto del azar? Sigamos analizando.

Diversificar

En Betaminic nos sugieren diversificar nuestra inversión, y dado que las cuatro estrategias son ganadoras (en teoría), lo ideal es aplicar las cuatro a la vez apostando una unidad cada vez que alguno de los sistemas dé una señal.

¿Y si varias estrategias entran en pérdidas a la vez?

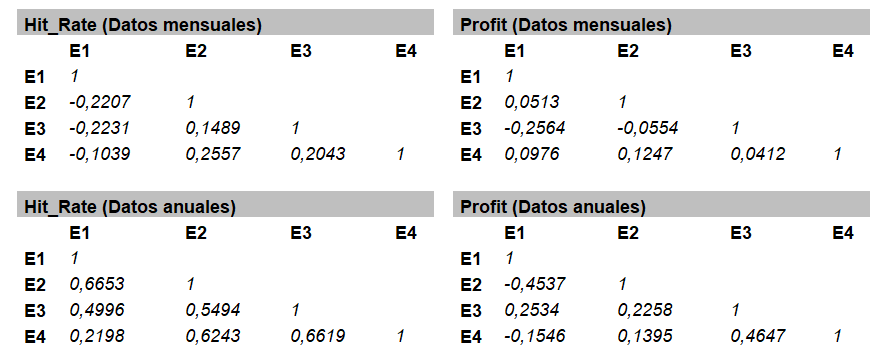

Mi recomendación para quien vaya a utilizar varias estrategias al mismo tiempo es que analice la correlación entre ellas. Lo ideal es que no estén muy correlacionadas unas con otras. De este modo se evitará que las rachas de una estrategia se agreguen sobre las rachas de otras ocasionando un gran desastre a nuestro bank ante una posible mala racha conjunta. Para asegurar este último punto, podemos crear una matriz utilizando la correlación de Pearson (r) para observar el grado de correlación entre las estrategias tal como se muestra a continuación:

En este caso he utilizado dos variables, Hit_Rate y Profit, con datos mensuales y anuales, ya que la muestra de picks es bastante considerable.

El coeficiente de correlación indica el grado de relación lineal entre dos variables y devuelve valores entre +1 y -1. Si existe correlación positiva los valores serán >0, si existe correlación negativa los valores serán <0, y si no existe relación estos valores serán bastante cercanos a 0. Valores cercanos a los extremos +1 y -1 indican una fuerte correlación positiva o negativa. Por tanto, lo que estamos buscando aquí son valores lo más cercanos a 0 posible. Para el caso que nos ocupa considero que existe una correlación positiva significativa a partir de +0,7 y -0,7 para una correlación negativa.

En los datos analizados no se observan valores significativos de correlación entre las estrategias de Betaminic en datos mensuales ni tampoco en datos anuales, aunque estos últimos sí devuelven algún coeficiente más alto entre alguna de las variables, pero nada significativo. Por tanto, podríamos sacar en conclusión que las estrategias no están correlacionadas y los resultados no se ven relacionados unos con otros. Esta afirmación siempre la hago desde la prudencia por supuesto.

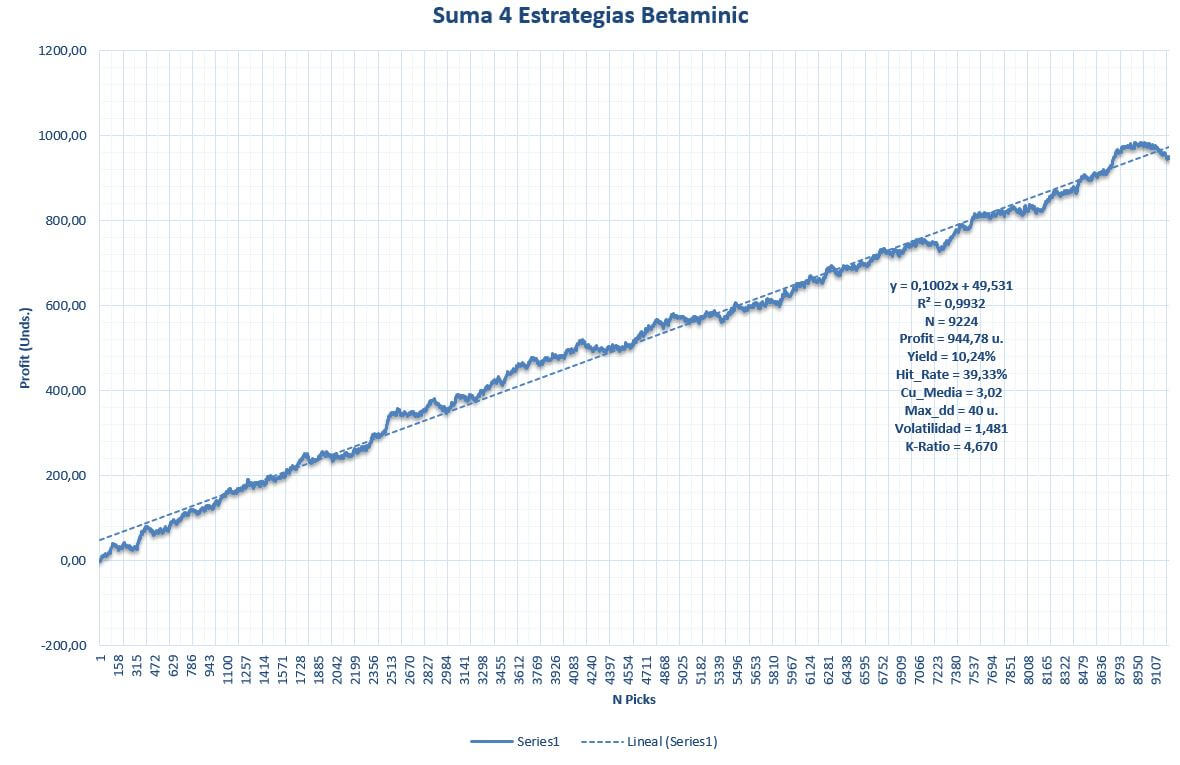

Balance de resultados de las cuatro estrategias aplicadas a la vez

En más de 5 temporadas el sistema global de las cuatro estrategias ha dejado un total 9.224 picks con un yield por encima del 10% y una volatilidad casi insignificante atendiendo a la cuota media y el extenso histórico.

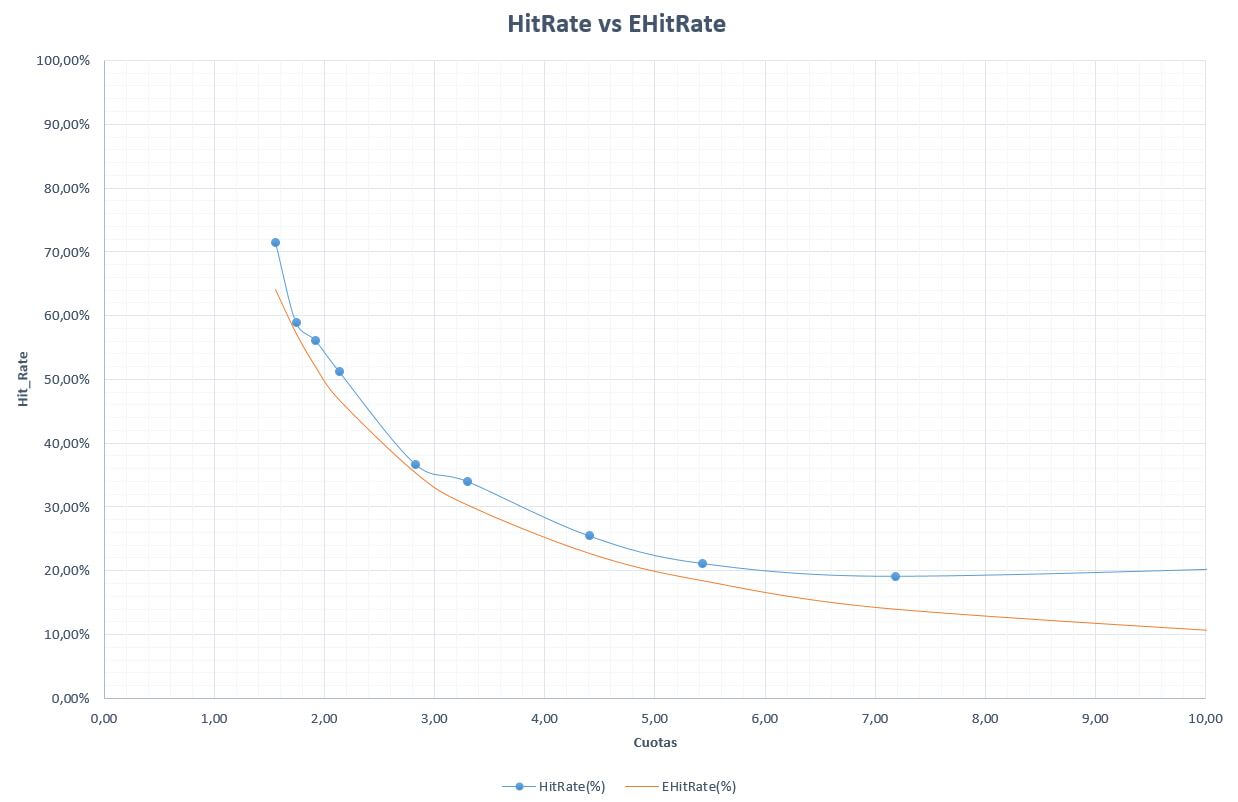

A continuación, analizamos un último grafico donde aparece el Hit_Rate obtenido comparado con el Hit_Rate mínimo necesario para no perder, fraccionado por tramos de cuotas.

Asombroso, el sistema global es ganador en todos los tramos de cuotas y es quizá este uno de los gráficos más interesantes y alentadores para los que se decidan a utilizar estos sistemas para apostar.

Prudencia

Con números en mano parece que estas estrategias son realmente buenas y de hecho me consta que ya hay muchos usuarios que las siguen, pero estos temas hay que tratarlos desde la más absoluta prudencia ya que como he comentado en este artículo bien puede existir una causalidad en los patrones que encontramos en muchas series de datos, pero no olvidemos que en toda serie hay parte de azar y este no puede ser menospreciado por el apostante.

Por ejemplo, si observamos detenidamente la estrategia de apostar al empate que propone Betaminic se ve cómo, si utilizamos únicamente las variables de control C1 y C2 que en teoría no deberían influir en el valor esperado, sí lo hacen. Tomando dichas variables el sistema encuentra algo más de 16 mil picks en la base de datos y su yield esperado debería rondar el -2,6%. En cambio se obtiene un valor cercano al +1,7% y esto no es nada más que azar. Por tanto, aunque la estrategia logra un yield mayor al 10% una parte de ese éxito sí podemos afirmar que está ayudado por el azar favorable.

Para concluir este artículo debo recordar en favor de Betaminic que utilizan nada más y nada menos que cuotas de cierre para contabilizar los beneficios y estas cuotas representan el punto de máxima eficiencia del mercado a largo plazo. Además, no hay filtro por ligas, entrando en juego más de 50 de ellas de diversos países.

En mi opinión estas estrategias son una idea bastante original que en backtest han dado unos resultados buenísimos y parece existir una causalidad que los explica en gran medida, pero recomendaría a todos los usuarios que se decidan a seguirlas que estudien bien el mercado y las ligas donde vayan a realizar sus apuestas. No olvidemos que rentabilidades pasadas no aseguran rentabilidades futuras.

Sobre el Autor. Dani es un apasionado del fútbol, del mundo de las apuestas, la quiniela y la estadística a todos los niveles, no solamente en el terreno de las apuestas deportivas, sino también en algunos campos sociológicos en los que está interesado. Lleva en el mundo de la quiniela aplicando la informática y la estadística desde hace más de 20 años y en las apuestas unos 12 años. Le encanta apostar y crear estrategias, no solamente en las casas de apuestas tradicionales, sino también en las casas de intercambio. Gran aficionado al fútbol y al snooker.

Para Betaminic ha sido todo un lujo el poder contar con la colaboración de Dani para este artículo, y esperamos poder disfrutar de sus conocimientos en futuras ocasiones.